Next.js'i Kurumsal Ölçeğe Taşımak: CDN'den API Gateway'e, Ölçeklendirme Rehberi

Next.js, kutudan çıktığı haliyle gayet iyi çalışır—ta ki trafik ve karmaşıklık belirli bir eşiği aşana kadar. İşte bu noktada, hiçbir şeyi sıfırdan yazmadan kurumsal ölçeğe nasıl geçeceğinizi anlatıyorum: cache ve CDN'den yatay ölçeklendirmeye, API Gateway'lerden Event-Driven Architecture'a kadar.

Next.js, React üzerine inşa edilmiş güçlü bir full-stack framework'tür. Server-Side Rendering (SSR) ve Static Site Generation (SSG) imkânı sunar. Sunucu tarafında UI oluşturmanıza olanak tanırken, veritabanları ve dosya sistemleri gibi sunucu tarafı kaynaklarına doğrudan erişim sağlar. Ayrıca Server Actions kullanarak frontend-backend iletişimini de kolaylaştırır.

Framework, minimum yapılandırma gerektiren ve küçük-orta ölçekli uygulamalar için oldukça etkili olan sofistike, yerleşik bir cache mekanizmasına sahiptir. Ancak büyük ölçekli kurumsal uygulamalarda üretime geçiş, daha derin bir mimari bilgi gerektirir. Ölçekte verimlilik ve sağlamlık sağlamak için geliştiricilerin varsayılan ayarların ötesine geçip ileri düzey optimizasyon tekniklerini birleştirme sanatını öğrenmeleri gerekir.

Sorunun Tanımı

Kurumsal seviyede, ölçeklenebilirlik başarının birincil ölçütü olduğunda, performansı korumak ve kaynakları etkin kullanmak için stratejik sistem tasarım kalıplarını uygulamak kritik önemdedir. Varsayılan framework yapılandırmalarına güvenmek başlangıç için yeterli olsa da, trafik arttıkça bu varsayılanlar darboğazlara dönüşerek sistem kararsızlığına ve artan operasyonel maliyetlere yol açabilir.

SLA, SLO ve Monitoring Kurulumu

Hizmet Kalitesi Tanımları: SLA ve SLO

Herhangi bir uygulamayı yayınlamadan önce, sistemin başarısını belirleyen fonksiyonel olmayan gereksinimleri tanımlamamız gerekir. Bunlar SLA ve SLO olarak kategorize edilir.

SLA (Service Level Agreement — Hizmet Seviyesi Sözleşmesi): Son kullanıcılarla hizmet kalitesini tanımlayan resmi bir sözleşmedir. Bu hedeflerin karşılanamaması genellikle finansal veya yasal yaptırımlarla sonuçlanır.

SLO (Service Level Objective — Hizmet Seviyesi Hedefi): Ulaşmayı amaçladığımız dahili bir hedeftir. Yaptırımlar devreye girmeden önce bir "güvenlik tamponu" sağlamak için genellikle SLA'dan daha katıdır.

Neden Net Hedefler Önemli?

Bu metriklerin belirlenmesi, bir sistemin "kullanılabilirliğini" tanımladığı için önemlidir. Bu hedefler genellikle şunlar tarafından yönlendirilir:

- Endüstri Standartları: Örneğin, Core Web Vitals. 2 saniyeyi aşan sayfa yüklenme süresi SEO sıralamalarına zarar verebilir, bu da düşük trafik ve gelire yol açar.

- Rekabet Karşılaştırmaları: Pazar rakiplerinin performansını eşleştirmek veya aşmak.

- Güvenlik ve Kritiklik: Yüksek riskli sistemlerde (otonom araçlar gibi) gerçek zamanlı doğruluk temel bir gerekliliktir; bu olmadan sistem temelden işe yaramaz.

Mühendislik ve İş Uyumu

Bu sayıları erken belirlemek, mühendislerin yapı taşlarını düzenlemesine ve kaynakları verimli bir şekilde tahsis etmesine olanak tanır. İş birimi hedefleri belirlerken, yazılım mühendisleri paydaşların teknik dengeleri ve her bir metriğin önemini anlamasına yardımcı olmalıdır.

Başarıyı Ölçmek: Monitoring ve Yük Testi

Hedef belirlemek savaşın sadece yarısıdır; bunları sürekli ölçüm ile doğrulamanız gerekir.

Faz A — Monitoring: Altyapımızı, fonksiyonel olmayan gereksinimleri gerçek zamanlı olarak izleyecek şekilde yapılandırmamız gerekir. Bu, mevcut uygulamanın tanımlı puanlarımızı karşılayıp karşılamadığını görmek için gereken verileri sağlar.

Faz B — Yük Testi: Sürprizlerden kaçınmak için gerçek dünya senaryolarını simüle eden yük testi araçları kullanırız. Sanal kullanıcılar ve sentetik trafik kullanarak, sistem pazara ulaşmadan önce stres testine tabi tutabiliriz.

Next.js Yaşam Döngüsü: Sunucu Tarafı ve Statik

Next.js'in iç mekaniklerini anlamak, ölçeklendirme için temeldir. Tek bir instance'tan düzinelerce replika başlatmaya geçtiğinizde, bir istek sırasında tam olarak ne olduğunu bilmek, darboğazları önceden tahmin etmenize ve kaynakları etkili bir şekilde yönetmenize olanak tanır.

1. Dinamik İstek Yaşam Döngüsü (SSR/ISR)

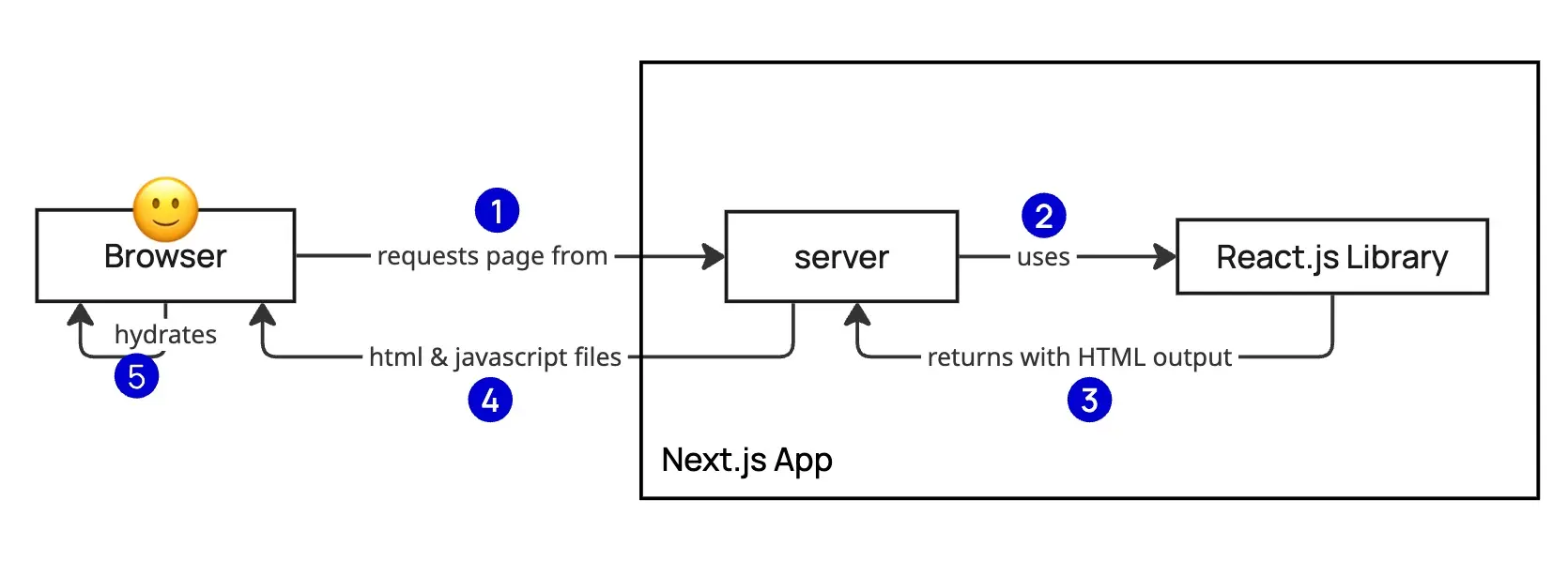

Kullanıcı çalışan bir Next.js uygulamasından bir sayfa talep ettiğinde, sunucu çok adımlı bir süreç başlatır:

1. Rendering: Next.js, istenen sayfayı sunucuda render etmek için dahili React motorunu kullanır. 2. Payload Teslimi: Sunucu, aşağıdakileri içeren bir yanıt oluşturur ve gönderir: - HTML: Tarayıcıda anlık görsel render için. - RSC Payload (React Server Components): İstemci tarafında hydration adımı için gereken özel bir veri formatı. 3. Hydration: Tarayıcı, statik HTML'i tam bir sayfa yeniden yüklemesi gerektirmeden etkileşimli hale getirmek için RSC payload'ını kullanır.

2. Statik Alternatif (SSG)

Uygulamanız tamamen sunucu tarafı bağımlılıkları olmadan (tamamen statik) oluşturulmuşsa, yaşam döngüsü önemli ölçüde değişir:

- Build Zamanı Üretimi: Tüm HTML, CSS ve JavaScript dosyaları build sürecinde bir kez üretilir.

- Statik Hosting: Her istekte çalıştırılacak bir mantık olmadığından, çalışan bir Node.js sunucusuna ihtiyaç duyulmaz. Bu dosyalar doğrudan global bir CDN veya basit bir web sunucusundan (Nginx veya Apache gibi) servis edilebilir.

- Ölçeklendirme Avantajı: Statik siteler, sunucu tarafı rendering'in CPU yükünü ortadan kaldırdığı için doğası gereği ölçeklendirmesi daha kolaydır.

İstek Akışının Detayları

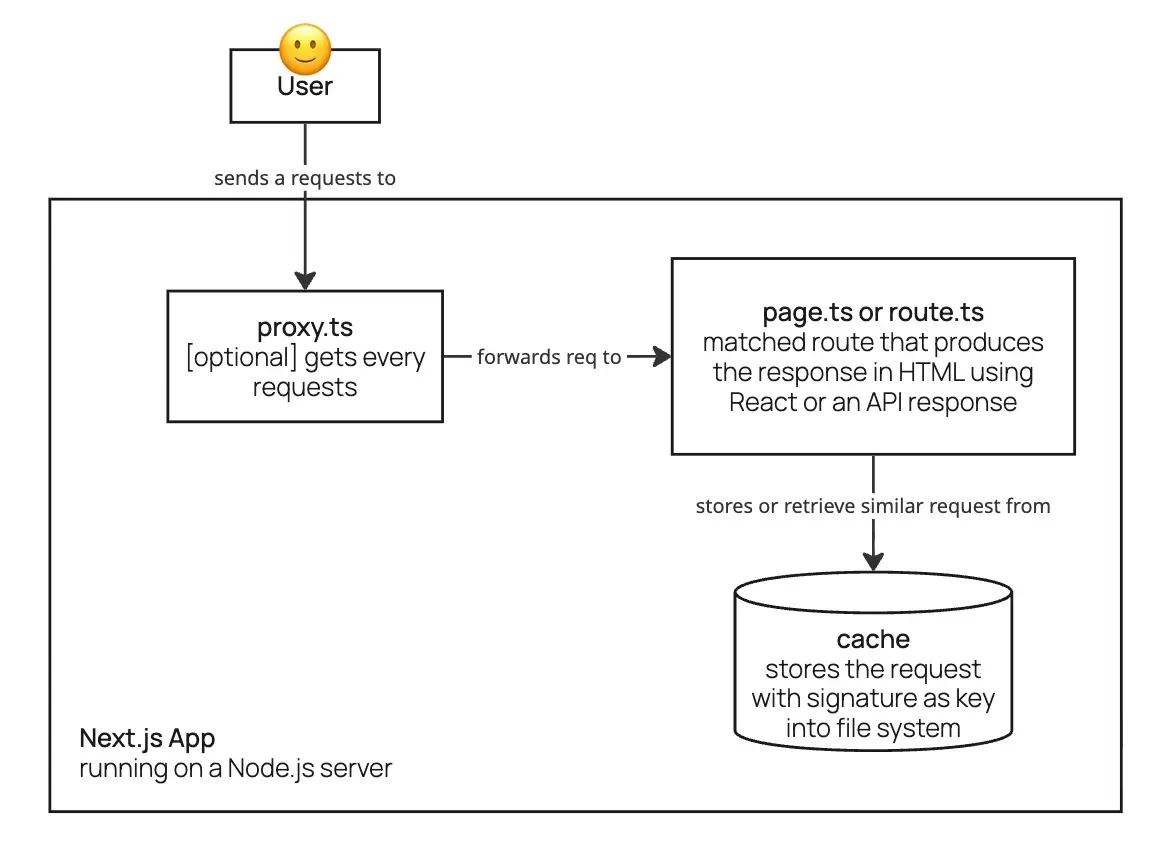

Bir istek Next.js uygulamasına girdiğinde, önce varolan proxy.ts (Next.js <15'te middleware olarak biliniyordu) tarafından yakalanır. Bu aşamada geliştiriciler genellikle isteğe devam edip etmeyeceğine karar verir — örneğin kimlik doğrulama yaparak.

İstek kabul edilirse, URL'ye göre uygun route tarafından işlenir. Bu aşamada Next.js, önce dahili cache'ini kontrol ederek benzer bir istek yapılıp yapılmadığını ve hâlâ geçerli olup olmadığını kontrol eder. Geçerli bir girdi varsa, daha hızlı yanıt için cache'lenmiş veriyi kullanır. Yoksa, Next.js yanıtı üretir, sunar ve gelecekteki kullanım için cache'ler.

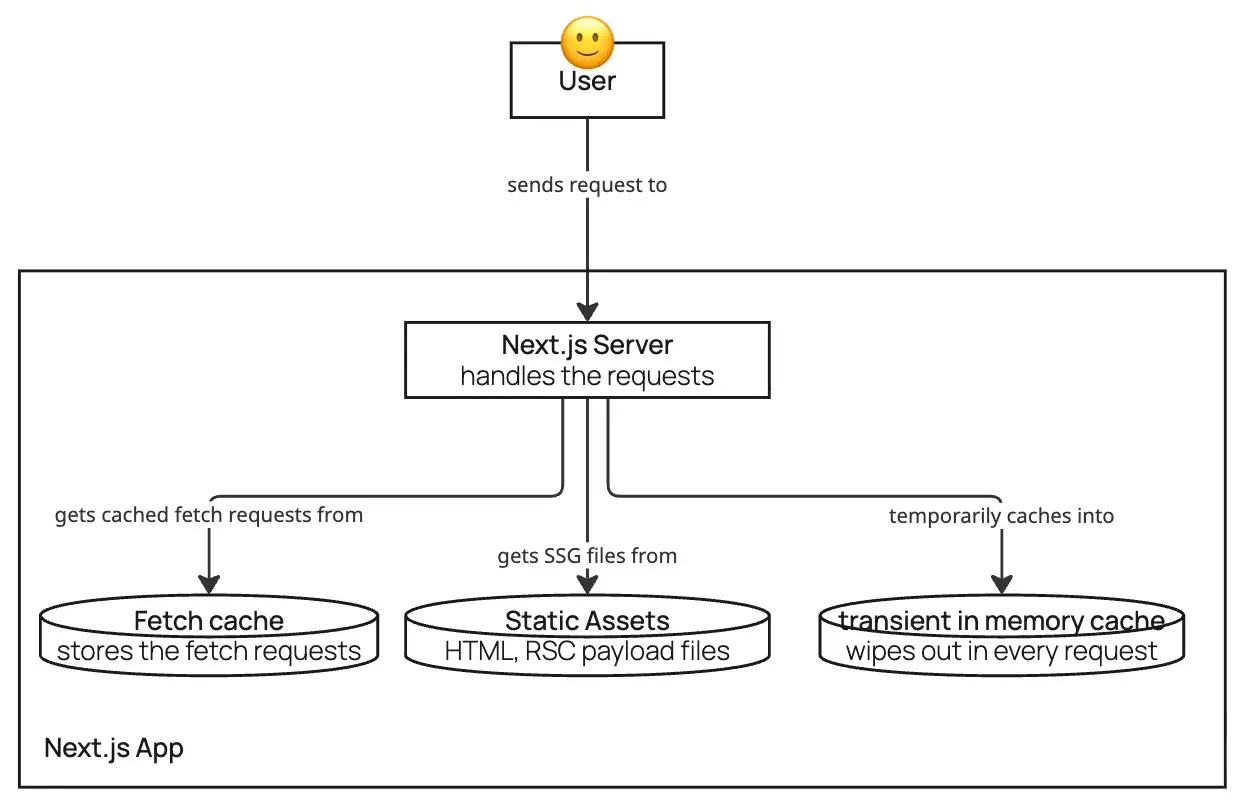

Next.js'te Cache Katmanları

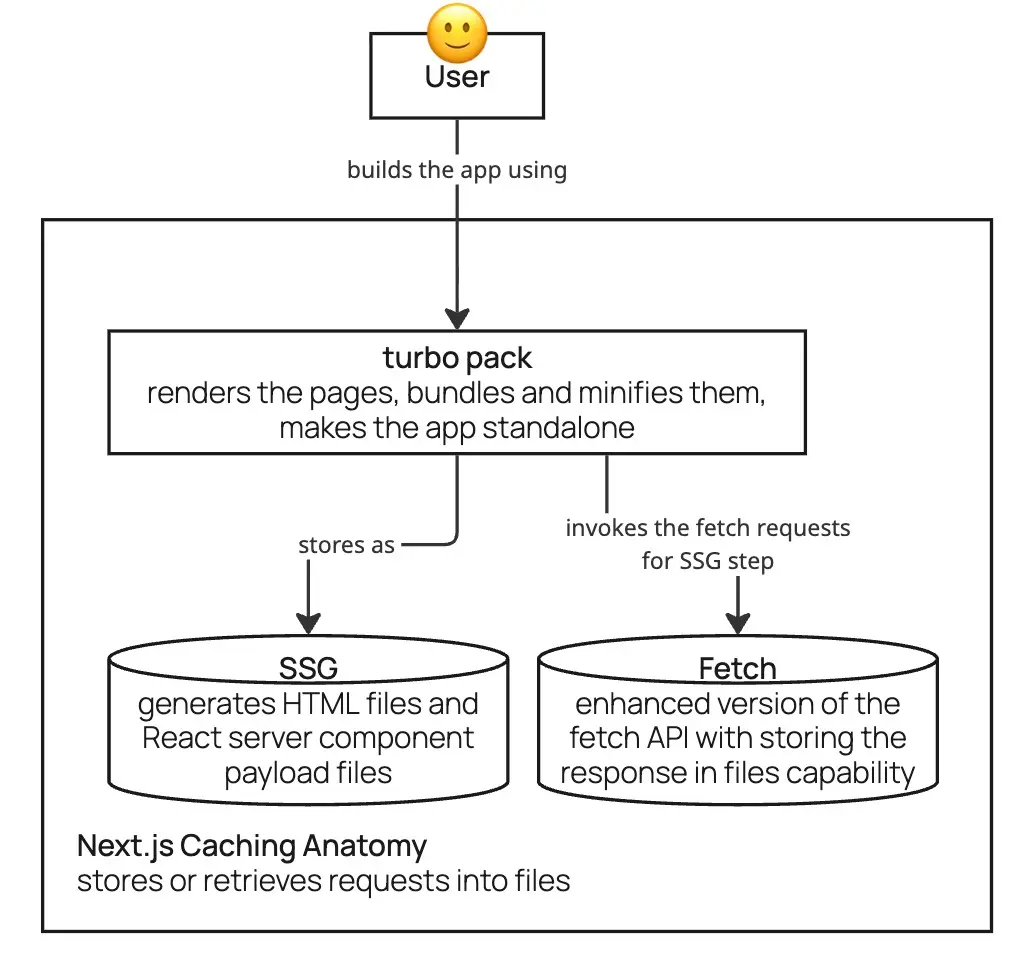

Next.js'te cache birkaç aşamada gerçekleşir:

Build Zamanı Cache: Kullanıcı uygulamayı build ettiğinde, Next.js standart CSS ve JS paketlerinin ötesinde statik varlıklar üretir. Bu, sayfaların HTML çıktısını içerir — kullanıcı Partial Prerendering (PPR) kullanırsa veya bir sayfayı tamamen dinamik olmaya zorlayacak sunucu tarafı kapasitelerinden kaçınırsa. Build sürecinde Next.js ayrıca React Server Component (RSC) payload dosyaları üretir ve bunları diğer paket dosyalarıyla birlikte saklar. Bir istek yapılmadan önce içerik ön-üretmenin bu yöntemine Static Site Generation (SSG) denir.

Çalışma Zamanı Cache: Uygulama çalışırken, Next.js gelen her istek için cache'te eşleşen bir girdi bulmaya çalışır. Bu cache, ön-üretilmiş HTML dosyalarını, React Server Component (RSC) payload'larını veya dosya sistemi içinde saklanan fetch istek sonuçlarını içerebilir. Ayrıca geliştirici React cache fonksiyonunu veya başka özel cache mekanizmaları uyguladıysa, bunlar da nihai yanıtı daha verimli üretmek için kullanılır.

Kritik Soru: Birden Fazla Instance

Cache mekanizmalarını incelediğimize göre kritik bir soru ortaya çıkar: aynı uygulamanın iki ayrı instance'ını çalıştırdığımızda ne olur? Her sunucunun cache'i arasında veri çoğaltılır mı? Doğal olarak cevap evet. Bu, yatay ölçeklendirmede çözmemiz gereken temel sorundur.

Next.js Uygulamanızı Performanslı Hale Getirin: Kolay Kazanımlar

Ölçeklendirme Stratejisi: Yatay Ölçeklendirmeden Önce Kolay Kazanımlar

Karmaşık yatay ölçeklendirmeye (ölçeği genişletme) geçmeden önce, bir uygulamayı minimum çabayla performans hedeflerini karşılayacak kadar sağlam hale getirebilecek "kolay kazanımlar" vardır.

1. CDN (Content Delivery Network)

CDN uygulamak, en düşük karmaşıklıkla tartışmasız en büyük Yatırım Getirisi'ni sağlar (ROI). Kodunuzda uygun cache header'ları ayarlayarak ve DNS'inizi bir CDN sağlayıcısına yönlendirerek, gecikmede %30–70 azalma elde edebilirsiniz. Global performans için yüksek etkili "ayarla ve unut" stratejisidir.

Örnek 1: Next.js Route Handler'da Cache-Control Header'ları Ayarlama

// /api/hello/route.ts

export async function GET() {

return NextResponse.json(

{ message: 'Hello World' },

{

status: 200,

headers: {

// CDN cache: 1 saat cache'le, revalidation sırasında eski içeriği sun

'Cache-Control': 'public, s-maxage=3600, stale-while-revalidate=59',

},

}

)

}Örnek 2: Statik varlıklar için cache header'larını özelleştirme

// next.config.ts

const nextConfig: NextConfig = {

async headers() {

return [

{

// /public/images/ altındaki tüm görselleri CDN'de 30 gün cache'ler

source: '/images/:path*',

headers: [

{

key: 'Cache-Control',

value: 'public, max-age=2592000, immutable',

},

],

},

{

// Next.js build tarafından üretilen JS/CSS chunk'larını 1 yıl cache'ler

source: '/_next/static/:path*',

headers: [

{

key: 'Cache-Control',

value: 'public, max-age=31536000, immutable',

},

],

},

]

},

}

export default nextConfigİlk örnek, CDN cache'lemesi için bir API yanıtına cache header'ları nasıl ayarlanacağını gösterir. İkinci örnek, statik görseller ve Next.js'in üretimde sunduğu JavaScript/statik dosyalar için cache header'larının nasıl özelleştirileceğini gösterir.

2. Dikey Ölçeklendirme

Dikey ölçeklendirme, ölçeklenebilirliği artırmanın hızlı ve etkili bir yoludur. Uygulama mantığınızı analiz ederek gerekli kaynak temelini belirleyebilir ve yoğun trafik için bir tampon ekleyebilirsiniz. Çoğu durumda, bu sıfır kod değişikliği gerektirerek yük altında sorunsuz çalışan bir uygulamayla sonuçlanır.

3. Kodlama En İyi Uygulamaları

Modern geliştirme tekniklerini benimsemek, altyapı değişikliği olmadan performansı önemli ölçüde artırabilir:

- Rendering Teknikleri: Async component'ler ve Partial Prerendering (PPR) uygulamak, içeriği daha hızlı sunarak Core Web Vitals'ı önemli ölçüde iyileştirir.

- DOM Optimizasyonu: DOM boyutunu azaltmak ve derin iç içe yapılardan kaçınmak, hem sunucu hem de istemcide rendering hızlarını artırır.

- Modern Framework'lerden Yararlanma: Next.js ve React'ın en son sürümleriyle güncel kalmak anlık faydalar sağlar: - React 19+: Daha verimli component'ler için otomatik memoization sağlayan React Compiler'ı tanıtır (yapılandırma ile etkinleştirilir). - Next.js 16+: Component'lerin veya Server Action'ların çıktısını önceki sürümlerden çok daha az çabayla cache'lemenize olanak tanıyan

use cache direktifini sunar.Partial Prerendering (PPR), Next.js 16+'da cacheComponents flag'i ile etkinleştirilir. Statik kabuk anında gönderilir; dinamik veya async içeriği

// next.config.ts

const nextConfig: NextConfig = {

cacheComponents: true,

}

// app/page.tsx – statik kabuk + dinamik içerik

export default function Page() {

return (

<>

<h1>Statik kabuk (anında gönderilir)</h1>

<Suspense fallback={<p>Yükleniyor…</p>}>

<AsyncContent />

</Suspense>

</>

)

}

async function AsyncContent() {

const data= await fetch('/api/data').then((r)=> r.json())

return <div>{data.message}</div>

}Yatay Ölçeklendirme: Replikalar ve Yük Dengeleme

Yatay ölçeklendirme (veya ölçeği genişletme), bir hizmetin replikalarını birden fazla makineye dağıtma sürecidir. Tek bir sunucuya güvenmek yerine, uygulama altyapı içindeki iki veya daha fazla düğüme kurulur. Bir Load Balancer (Yük Dengeleyici), giriş noktası görevi görerek gelen trafiği bu instance'lar arasında dağıtır. Load Balancer, istekleri yönlendirmek için belirli algoritmaları kullanan özel yazılım (Nginx gibi) çalıştıran bir sunucudur:

- Round Robin: İstekleri sırayla dağıtır, her sunucuya sırayla bir tane verir.

- Weighted Round Robin: Her sunucunun verim veya kapasitesine göre istek atar.

- Least Connections: Yeni istekleri o anda en az aktif bağlantıya sahip sunucuya gönderir.

- IP Hash: İstekleri istemcinin IP adresine göre yönlendirir, böylece aynı kullanıcı her zaman aynı sunucuya yönlendirilir.

Ölçeklendirmenin Mimari Zorlukları

Yatay ölçeklendirme, sistem güvenilirliğini sağlamak için ele alınması gereken mimari karmaşıklıklar getirir.

1. Durumsuzluk (Statelessness) Sağlamak

Etkin ölçeklendirme için bir uygulama durumsuz olmalıdır. Bu, herhangi bir replikanın, kullanıcının önceki etkileşimlerinden bağımsız olarak herhangi bir gelen isteği işleyebilmesini sağlar.

- Harici Durum Yönetimi: Uygulama durum gerektiriyorsa (kullanıcı oturumları gibi), bu veri veritabanı veya global cache gibi paylaşılan bir kaynağa taşınmalıdır.

- Yapışkan Oturumlar (Sticky Sessions): Tam durumsuzluk sağlanamıyorsa, Load Balancer bir IP Hash algoritması ile yapılandırılabilir. Bu, belirli bir kullanıcının isteklerinin her zaman aynı sunucuya yönlendirilmesini sağlayan "yapışkan oturumlar"ı etkinleştirir.

2. Dağıtılmış Cache Sorunu

Daha önce tartışıldığı gibi, Next.js varsayılan olarak cache girdilerini yerel dosya sisteminde saklar. Çoklu instance kurulumunda bu, "soğuk cache" sorununa ve her sunucunun kendi izole verisine sahip olması nedeniyle daha yüksek cache-miss oranlarına yol açar. Bunu çözmek için tüm instance'ların erişebileceği paylaşılan bir cache uygulamanız gerekir. İki temel yöntem vardır:

- Paylaşılan Sanal Sürücü: Tüm instance'lar arasında paylaşılan bir sürücü bağlamak. Bu, genellikle eşzamanlılık darboğazlarına ve ölçeklendirme sorunlarına yol açtığından önerilmez.

- Redis Cache Cluster: Redis gibi bir cluster kullanarak Next.js'te özel bir cache handler uygulamak. Bu, tüm replikaların tek bir yüksek performanslı kaynaktan cache girdilerini saklamasına ve almasına olanak tanır.

> Kaynak: Resmi Next.js Redis Cache Handler örneği üzerinden bunun nasıl uygulanacağını keşfedebilirsiniz.

Stratejik Ölçeklendirme ve Otomasyon

Alan Odaklı Ölçeklendirme (Micro-Frontend'ler)

Tüm sistemi çoğaltmak yerine, uygulamayı Domain-Driven Design (DDD) temelinde Micro-Frontend'lere bölebilirsiniz. Bu, daha yüksek talep gören belirli alanları ölçeklendirmenize olanak tanır. Örneğin, bir e-ticaret platformunda "Ürün" servisi yüksek trafiği karşılamak için on replikaya ihtiyaç duyabilirken, "Profil" servisi yalnızca ikiye ihtiyaç duyabilir.

Kubernetes (K8s) ile Otomatik Ölçeklendirme

Modern altyapılar genellikle kaynakları otomatik olarak yönetmek için Autoscaling kullanır. Kubernetes gibi teknolojiler, uygulamanızın Docker'ize edilmiş sürümlerini alır ve gerçek zamanlı talebe göre replika sayısını dinamik olarak yukarı veya aşağı ölçeklendirir. Bu, trafik artışlarında yüksek performansı garanti ederken, düşük trafik dönemlerinde gereksiz instance'ları devre dışı bırakarak maliyetleri azaltır.

API Gateway

Tekrarlayan mantığı özel bir katmanda merkezileştirmek, ölçeklenebilirliği ve bakım kolaylığını artırır; cache ve kimlik doğrulama gibi çapraz kesişen konuların optimize edilmesi ve uygulanması daha kolay hale gelir. Çıkarma için yaygın bir aday kimlik doğrulamadır: Her uygulama bir isteği kabul etmeden önce kullanıcıyı tekrar tekrar doğruladığında (örneğin Next.js'teki proxy.ts aracılığıyla), bu mantık ayrı, paylaşılan bir hizmet için güçlü bir adaydır.

API Gateway bu rolü, yetkisiz erişimden korunması gereken altyapının önünde durarak yerine getirir. İç servisleri kamusal erişimden gizleyen bir ters proxy (reverse proxy) olarak davranır ve genellikle HTTPS sonlandırma noktası olarak hizmet eder.

Gateway TLS'i sonlandırdıktan sonra, gateway ile iç servisleriniz arasındaki trafik düz HTTP kullanabilir, çünkü kendi ağınız içinde kalır. Bu, overhead'i azaltır ve iç iletişimi basitleştirir.

API Gateway uygulamak genellikle Nginx gibi bir ters proxy dağıtmayı (veya bulut sağlayıcınızdan yönetilen bir eşdeğeri, ki bu da kullanılabilirliği de yönetir) içerir. Korunan rotalar için proxy, kimlik doğrulamasını yalnızca istek header'larını özel bir auth servisine ileterek doğrulamak üzere yapılandırılır. Token geçersizse gateway uygun HTTP durumunu (örneğin 401) döndürür ve isteği uygulamaya iletmez.

Aşağıdaki Nginx yapılandırması bu kalıbı göstermektedir:

http {

# 1. Mikro servislerinizin konumlarını tanımlayın

upstream cart_app { server localhost:3001; }

upstream product_app { server localhost:3002; }

upstream profile_app { server localhost:3003; }

server {

listen 80;

# 2. Dahili Kimlik Doğrulama Kontrolü

# Nginx'in token'ın geçerli olup olmadığını "sorduğu" yer

location = /auth-verify {

internal;

proxy_pass http://your-auth-api/validate;

proxy_pass_request_body off;

proxy_set_header Content-Length "";

}

# 3. Korunan Rotalar

location /cart {

auth_request /auth-verify;

proxy_pass http://cart_app;

}

location /product {

auth_request /auth-verify;

proxy_pass http://product_app;

}

location /profile {

auth_request /auth-verify;

proxy_pass http://profile_app;

}

# 4. Hata İşleme

# Auth servisi 401 döndürürse, Nginx bunu kullanıcıya iletir

error_page 401 = @error401;

location @error401 {

return 401 "Unauthorized - Geçersiz Token";

}

}

}Dosya Yüklemelerini Optimize Etmek: Yerel Depolamadan Blob Storage'a

Web geliştirmede yaygın bir kalıp, dosyaları doğrudan form gönderimlerini işleyen aynı sunucuya yüklemektir. Basit olsa da bu yaklaşım, kurumsal seviye uygulamalar için önemli zorluklar sunar.

Yerel Dosya Depolamanın Dezavantajları

Kullanıcı tarafından yüklenen dosyaları doğrudan uygulama sunucunuzda depolamak üç temel risk getirir:

1. Düşük Dayanıklılık (Durability): Dosyalar sunucunun yerel diskinde depolanıyorsa, bir donanım arızası veya sunucu çökmesi kalıcı veri kaybına yol açabilir. 2. Azaltılmış Ölçeklenebilirlik: Büyük dosya aktarımları önemli miktarda bant genişliği ve CPU döngüsü tüketir, sunucuyu bunaltır ve diğer kullanıcı isteklerini verimli bir şekilde işlemesini engeller. 3. Altyapı Yükü: Dosyaları uygulama sunucusundan daha kalıcı bir depolama konumuna sonra taşımak gereksiz dahili trafik ve karmaşıklık oluşturur.

Modern Çözüm: Blob Storage ve Signed URL'ler

Dosya yüklemelerini ele almanın endüstri standardı yaklaşımı, Amazon S3, Google Cloud Storage veya Azure Blob Storage gibi bir Blob Storage hizmetinin kullanılmasıdır. Bu hizmetler şunları sunar:

- Yüksek Dayanıklılık: Dosyalar replika setleri arasında yönetilir ve donanım arızası durumunda bile güvende kalmaları sağlanır.

- Artırılmış Kullanılabilirlik: Dosya yönetimini devretmek, uygulama sunucunuzun mantık ve yönlendirme işlemlerine odaklanmasını sağlar.

- Signed URL'ler ile Doğrudan Yükleme: Bu verimlilik için kritik bir özelliktir. Dosyanın sunucunuzdan geçmesi yerine, uygulamanız geçici bir Signed URL oluşturur. Kullanıcının tarayıcısı daha sonra dosyayı doğrudan Blob Storage hizmetine yükler.

Doğrudan yüklemeleri uygulayarak, dosya aktarım yükünü altyapınızdan etkili bir şekilde kaldırırsınız. Bu, sisteminizi daha ölçeklenebilir yapar, gecikmeyi azaltır ve uygulamanızın çok daha yüksek hacimde isteği işleyebilmesini sağlar.

Event-Driven Architecture: Yüksek Hacimli Etkileşimleri Ölçeklendirmek

Bazen tek bir kullanıcı etkileşimi, bir dizi dahili servis çağrısını tetikler. Örneğin, kullanıcı "Sepete Ekle" düğmesine tıkladığında, genellikle bir dizi olay takip eder:

1. Sepet Servisi: Ürünü kullanıcının sepetinde saklamak. 2. Analitik: Harici bir izleme aracına veri göndermek. 3. Loglama: İzleme için sistem loglarını toplamak. 4. Envanter (SAP): Ürün kullanılabilirliğini düşmek için ERP servislerini çağırmak.

Binlerce kullanıcı bu işlemi aynı anda gerçekleştirdiğinde, on binlerce çağrı ile sonuçlanır. Bunlar senkron olarak işlenirse (birinin bitmesini bekleyerek bir sonrakini başlatma), sistem hızla yavaşlar veya yük altında çöker.

Event-Driven Architecture ile Ayrıştırma

Yüksek performans ve ölçeklenebilirlik sağlamak için üstün bir yaklaşım, bu servisleri Event-Driven Architecture (EDA) kullanarak ayrıştırmaktır. Uygulamanın her servisin yanıt vermesini beklemek yerine, basitçe bir "olay" yayınlar.

- Asenkron Çağrılar: Birincil kullanıcı eylemi (sepete ekleme) anında tamamlanır ve alt görevler arka planda işlenir.

- Yüksek Verimli İşleme: Kafka gibi bir event bus kullanmak, sistemin muazzam hacimde veri almasına olanak tanır. Kafka bir tampon görevi görür ve alt servisler (eski bir SAP sistemi gibi) yavaş olsa bile ana uygulamanın kullanıcıya duyarlı kalmasını sağlar.

- Sistem Dayanıklılığı: Analitik veya loglama servisi çökerse, "Sepete Ekle" eylemi yine de başarılı olur ve olaylar servisler tekrar çevrimiçi olduğunda işlenir.

İletişim Protokollerini Optimize Etmek: HTTP/2 ve gRPC

Doğru iletişim protokolünü seçmek, yüksek kaliteli, modern bir altyapıyı sürdürmek için hayati önem taşır. Eski protokollerden HTTP/2 ve gRPC'ye yükseltmek, verim, ölçeklenebilirlik ve genel sistem performansını önemli ölçüde artırır.

1. HTTP/2'nin Avantajları

HTTP/2, HTTP/1.1'in darboğazlarını çözen birkaç temel özellik sunar:

- Multiplexing: Tek bir TCP bağlantısı üzerinden birden fazla istek ve yanıtın gönderilmesine olanak tanır, yeni bağlantı açma overhead'ini büyük ölçüde azaltır.

- İkili Çerçeveleme (Binary Framing): Verileri düz metin yerine ikili formata kodlar, makinelerin ayrıştırmasını çok daha hızlı hale getirir.

- Header Sıkıştırma (HPACK): İstek ve yanıt header'larının boyutunu azaltır, bant genişliğinden tasarruf sağlar ve gecikmeyi iyileştirir.

Nginx Yapılandırması: Nginx'te HTTP/2'yi etkinleştirmek için listen direktifinize http2 parametresini eklemeniz yeterlidir:

server {

listen 443 ssl http2;

server_name api.example.com;

# ...

}2. Servisler Arası İletişim: gRPC ve REST Karşılaştırması

REST halka açık API'ler için yaygın olsa da, gRPC dahili servisler arası iletişim için genellikle üstün bir tercihdir.

- Verimlilik: gRPC, varsayılan olarak transport katmanı olarak HTTP/2 kullanır ve tüm performans avantajlarını devralır.

- Protocol Buffers (Protobuf): Genellikle metin tabanlı JSON kullanan REST'in aksine, gRPC ikili format kullanır. Bu, önemli ölçüde daha küçük payload'lar ile sonuçlanır ve serileştirme ve ayrıştırma için gereken CPU overhead'ini azaltır.

- Güçlü Tip Tanımlaması: gRPC, tanımlanmış servis sözleşmeleri gerektirir ve bu da mikro servisler arasındaki iletişimde hataları azaltır.

Sonuç ve Pratik Tavsiyeler

Next.js'i kurumsal ölçeğe taşımak, varsayılanların ötesine geçmek demektir: SLA'lar ve SLO'lar tanımlamak, istek yaşam döngüsünü ve cache davranışını anlamak, ardından CDN, paylaşılan cache ile yatay ölçeklendirme, API Gateway'ler, Blob Storage, Event-Driven veya HTTP/2/gRPC tabanlı iletişimi uygun yerlere katmanlamak.

Hiçbir ekip her şeyi bir anda benimseyemez — ve bu gayet normaldir. En yüksek etkili, en düşük sürtünmeli kazanımlarla başlayın (örneğin CDN ve cache header'ları veya auth'u API Gateway'in arkasına taşımak), SLO'larınıza göre ölçün, ardından yineleyin.

Hedef, trafik ve karmaşıklık arttıkça performanslı ve bakımı kolay kalan bir sistemdir. Bu yazıdaki alanlardan mevcut darboğazınıza uyanı seçin ve bir sonraki sprint'inizde deneyin.

Önemli Hatırlatmalar:

- Ölçeklendirmeye başlamadan önce mutlaka monitoring ve load testing altyapınızı kurun

- CDN, en düşük maliyetli ve en yüksek ROI'li ilk adımdır

- Redis cache cluster, Next.js'in çoklu instance'ları arasında tutarlılık sağlar

- API Gateway, tekrarlayan güvenlik mantığını merkezileştirir

- Event-Driven Architecture, yüksek hacimli etkileşimlerde sistem dayanıklılığı sağlar

- HTTP/2 ve gRPC, servisler arası iletişimde büyük performans kazandırır